我们的使命:将 100 万个 GPU 整合到 DePIN – 去中心化的物理基础设施网络中。

io.net Cloud 是一个最先进的去中心化计算网络,允许机器学习工程师以可比集中式服务的一小部分成本访问分布式云集群。

io.net Cloud 是一个最先进的去中心化计算网络,允许机器学习工程师以可比集中式服务的一小部分成本访问分布式云集群。

现代机器学习模型经常利用并行和分布式计算。利用多个系统中多个内核的强大功能来优化性能或扩展到更大的数据集和模型至关重要。训练和推理过程不仅仅是在单个设备上运行的简单任务,而且通常涉及协同工作的协调 GPU 网络。

不幸的是,由于公有云中需要更多的 GPU,获得对分布式计算资源的访问带来了一些挑战。一些最突出的是:

- 数量有限: 使用 AWS、GCP 或 Azure 等云服务访问硬件通常需要数周时间,而且常用的 GPU 型号通常不可用。

- 糟糕的选择:用户在 GPU 硬件、位置、安全级别、延迟和其他选项方面几乎没有选择。

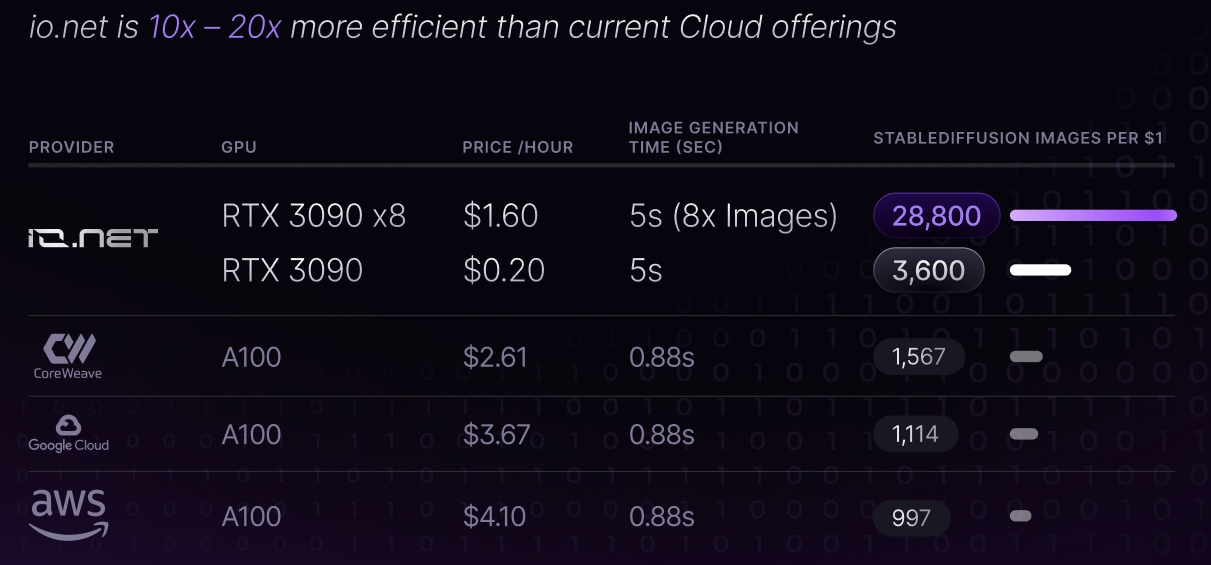

- 高成本: 获得好的 GPU 非常昂贵,项目每月很容易花费数十万美元用于训练和推理。

io.net 通过聚合来自未充分利用的来源(如独立数据中心、加密矿工以及 Filecoin、Render 等加密项目)的 GPU 来解决这个问题。这些资源被组合在一个分散的物理基础设施网络(DePIN)中,使工程师能够在一个可访问、可定制、经济高效且易于实施的系统中访问大量的计算能力。

借助 io.net,团队只需极少的调整即可跨 GPU 网络扩展工作负载。该系统处理编排、调度、容错和扩展,并支持预处理、分布式训练、超参数调优、强化学习和模型服务等多种任务。它旨在为 Python 工作负载提供通用计算。

借助 io.net,团队只需极少的调整即可跨 GPU 网络扩展工作负载。该系统处理编排、调度、容错和扩展,并支持预处理、分布式训练、超参数调优、强化学习和模型服务等多种任务。它旨在为 Python 工作负载提供通用计算。

io.net 产品专为四个核心功能而构建:

- 批量推理和模型服务:通过将训练模型的架构和权重导出到共享对象存储,可以并行化对传入的批处理数据执行推理。io.net 允许机器学习团队跨分布式 GPU 网络构建推理和模型服务工作流。

- 平行培训:在单个设备上训练模型时,CPU/GPU 内存限制和顺序处理工作流程是一个巨大的瓶颈。io.net 利用分布式计算库来编排和批量训练作业,以便可以使用数据和模型并行性在许多分布式设备中并行化这些作业。

- 并行超参数调优: 超参数调优实验本质上是并行的,io.net 利用具有高级超参数调优的分布式计算库来检查最佳结果、优化调度和简单地指定搜索模式。

- 强化学习:io.net 使用开源强化学习库,该库支持生产级、高度分布式的强化学习工作负载以及一组简单的 API。

这一切都始于 2023 年 2 月的 Solana 黑客马拉松和 Solana Austin Hacker House

大约2个月前更新

正文完